FAGARTIKKEL

Dataetterforskere – mennesker eller maskiner?

En studie med 53 dataetterforskere som undersøkte samme databeslag viser at det er stor variasjon i hvilke spor man finner, hvordan man fortolker sporene man finner og hvordan man konkluderer.

Studien viser også at saksinformasjon påvirker hvor mye informasjon man finner under gjennomgangen av beslaget.

Digitale spor og bevis blir gjerne omtalt som objektiv informasjon, og vurderes ofte som pålitelige og verdinøytrale, sammenlignet med for eksempel vitnebevis. Men, også et databevis blir gjenstand for «menneskelig behandling» før det får noen rolle i straffesaken.

Det er mennesket som vurderer om funnet er relevant nok for straffesaken til å tas med i rapporten, som fortolker hva funnet betyr og som konkluderer eller oppsummerer hvilken verdi funnet har for straffesaken.

Det finnes mye forskning på feil i teknologi og verktøy, men langt mindre på den menneskelige faktors betydning for databevisets kvalitet. Forskning fra ulike kriminaltekniske og rettsrelevante vitenskapelige disipliner, som fingeravtrykk, DNA og rettsmedisin, har vist at den menneskelige faktor kan føre til feil både når sporene undersøkes og når det trekkes konklusjoner. Det er hovedsakelig to faktorer som brukes for å identifisere omfanget av feil.

Den første er bias, eller kognitive slagsider – som kan gi systematiske avvik fra et optimalt utfall. Den andre er reliabilitet, eller støy (engelsk «noise») – som kan føre til vurderinger og beslutninger som spriker i ulike retninger. I den nylig utgitte boken «Noise» hevder Kahneman med flere følgende: «Wherever there is judgement, there is noise – and more of it than you think».

Den menneskelige faktor

For å undersøke om den menneskelige faktor har betydning for kvaliteten på beviset ved analyse av databeslag, ble det gjennomført et eksperiment med 53 dataetterforskere fra 8 land, hvorav 44 var norske.

Deltakerne fikk tilgang til samme beslagsfil og lik bakgrunnsinformasjon om saken. Oppdraget deres var å analysere beslagsfilen ved hjelp av maskinvare og verktøy som de normalt ville brukt og ved å utforme rapporten som de ville gjort i en reell sak.

For å undersøke om informasjon fra straffesaken påvirker undersøkelsene (biasibilitet), ble deltakerne delt inn i 4 grupper som hver fikk ulik kontekstuell straffesaksinformasjon som ikke hadde direkte relevans for undersøkelsene. En gruppe fikk vite at mistenkte hadde tilstått.

En annen fikk vite at dette trolig var et phishing-angrep, som indikerte at mistenkte var uskyldig. En tredje gruppe fikk vite at det var en pågående lønnskonflikt i firmaet hvor mistenkte sympatiserte med de ansatte, noe som indikerte at mistenkte kunne ha et motiv for å ta del i informasjonslekkasjen. Den siste gruppen – kontrollgruppen - fikk ingen informasjon utover bakgrunnsinformasjonen.

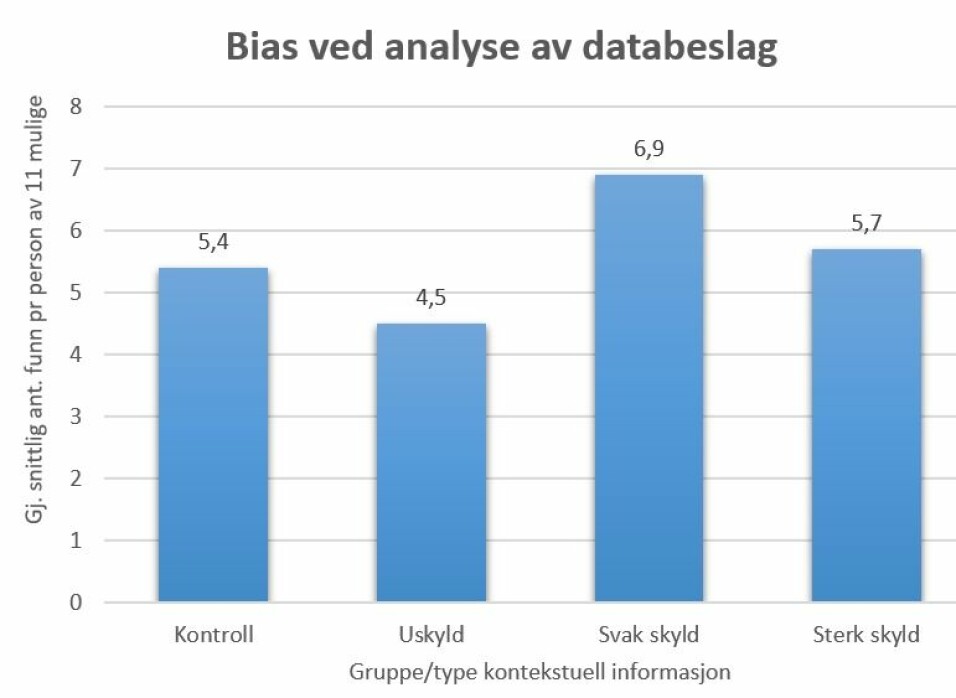

Funnene viser at straffesaksinformasjonen har betydning for hvor mange spor deltakerne fant. De som fikk høre om lønnskonflikten (figur 1: «Svak skyld») fant flere spor enn de andre gruppene. De som fikk vite at det kunne være et phishing-angrep (figur 1: «Uskyld»), fant færrest spor. Informasjonen om tilståelse (figur 1: «Sterk skyld») så ikke ut til å ha noen effekt. Denne gruppen fant omtrent like mange spor som kontrollgruppen (figur 1.: «Kontroll»).

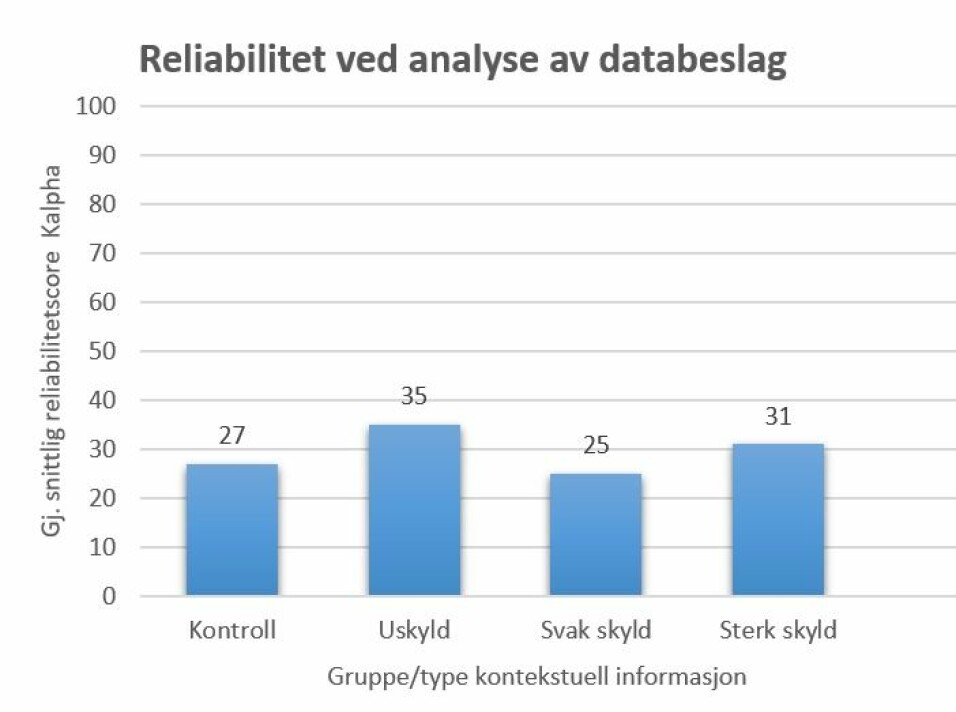

Hver gruppe ble også undersøkt for å måle reliabiliteten. Reliabilitet handler om hvor konsistent man er under like forutsetninger, altså om deltakerne innad i hver gruppe fant den samme informasjonen, om de fortolket den likt og om de vurderte den likt med hensyn til om den indikerte straffeskyld eller uskyld for den mistenkte.

En score over 80 indikerer høy reliabilitet, mellom 67-80 indikerer diskutabel reliabilitet, mens score under 67 indikerer lav reliabilitet. Resultatene (figur 2) viser gjennomgående lav reliabilitet, altså stor variasjon, innenfor alle de tre områdene som ble målt. Det tyder på at dersom én dataetterforsker analyserer en beslagsfil, og en annen gjennomfører en re-analyse av samme fil under like forutsetninger, så er det lav sannsynlighet for at de finner de samme sporene, fortolker dem likt og konkluderer likt om hvorvidt sporene indikerer straffeskyld eller uskyld for mistenkte. Sagt med andre ord: De ville trolig skrevet nokså ulike analyserapporter.

Et åpent sinn

Studien er den første som belyser biasibilitet og reliabilitet i analyse av databeslag, og er alene ikke nok til å konkludere. Funnene er imidlertid viktige for å slå hull på myten om objektive og pålitelige databevis, og de kan gi oss en pekepinn på hvor vi bør sette inn tiltak for å forebygge og/eller avdekke feil ved analyse av databeslag. Funnene viser at straffesaksinformasjon kan lede til bias – også for dataetterforskere.

Innenfor mange kriminaltekniske eller rettsrelevante vitenskapelige disipliner vil man kunne minimere bias forårsaket av straffesaksinformasjon ved å sørge for at informasjon som er irrelevant for undersøkelsene ikke tilflyter den som skal gjennomføre undersøkelsen. Dette er imidlertid ikke like lett i undersøkelser av databeslag, hvor den som gjennomgår ofte allerede har en rolle i straffesaken, og har tilgang til informasjon for eksempel gjennom saksmøter og Indicia-prosjektet. Dessuten er tilgang til straffesaksinformasjon i mange tilfeller nødvendig for å kunne fange opp relevant informasjon ved gjennomgangen av beslaget.

En hypotesebasert tilnærming, med alternative forklaringer som ivaretar både skyld og uskyld for mistenkte, vil derfor kunne være et nærliggende tiltak i denne sammenheng. Funn fra studien viste at de som hadde fått den mest tvetydige informasjonen, var de som fant flest spor. Det kan tyde på at et åpent sinn omkring hva som kan ha skjedd, kan lede til at man leter lenger og finner mer informasjon, og motsatt, at en oppfatning om skyld eller uskyld for mistenkte kan lede til at undersøkelsene avsluttes når man anser oppfatningen som tilstrekkelig bekreftet gjennom funn.

Funnene omkring lav reliabilitet indikerer at kvalitetskontroll bør innarbeides som et obligatorisk steg ved undersøkelser av databeslag. For å styrke databevisenes kvalitet, og rettssikkerheten til de impliserte i straffesaken, bør en fagfelle med tilstrekkelig kompetanse vurdere rapportens innhold og konklusjoner og verifisere viktige funn før den regnes som klar til å inngå i straffesaken. Agder politidistrikt er allerede i gang med dette arbeidet, og jeg håper flere politidistrikter følger etter.